为了保证安全,自动驾驶汽车必须准确跟踪行人,自行车和周围其他车辆的运动。因此,卡内基梅隆大学开发了一种新方法,训练这些跟踪系统让它们更有效。

一般而言,可用于训练跟踪系统的道路和交通场景数据越多,结果越好。为此,CMU研究人员找到了一种获得大量自动驾驶数据的方法。

“与以前的方法相比,我们的方法更加健壮,因为我们可以在更大的数据集上进行训练,”与CMU机器人学院助理教授David Held合作的研究实习生Himangi Mittal说。

场景流估计

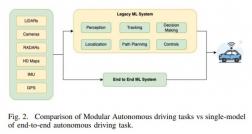

CMU这种方法是最近比较流行的所谓场景流估计,就是光流的三维版本,表述了图像/点云中每个点在前后两帧的变化情况。目前对场景流的研究还局限在实验室阶段,由于缺乏实际数据(打标成本太高)以及客观的评价指标,离工程应用还有不小的距离。此外,巨大的计算量也是一个瓶颈。

大多数自动驾驶汽车主要基于称为激光雷达的传感器进行导航,该激光设备会生成有关汽车周围环境的3D信息。这种3D信息不是图像,而是点云。车辆利用此数据的一种方式是使用一种称为场景流的技术。这涉及计算每个3D点的速度和轨迹。通过场景流将一起移动的点组解释为车辆,行人或其他移动物体。

过去,用于训练此类系统的最新方法要求使用标记的数据集,已标注注释的传感器数据,会随时间推移跟踪每个3D点。手动标记这些数据集既费力又昂贵,因此,几乎没有标记数据集。所以,场景流训练通常是使用效果不佳的模拟数据执行的,然后使用少量存在标记的真实世界数据进行微调。

CMU提出的一种自我监督的场景流估计方法。使用COM两个自我监督损失的组合,模拟由人类注释创建的监督,即使用未标记的数据进行场景流训练。同时,使用周期一致性损失,以确保产生的场景流在时间上是一致的。由于通过在汽车上安装激光雷达并四处行驶,相对容易生成未标记的数据,因此不乏这些数据。

他们方法的关键是为系统开发一种方法来检测场景流中的自身错误。在每个瞬间,系统都会尝试预测每个3D点的移动方向和移动速度。在下一瞬间,它会测量该点的预测位置与最接近该预测位置的点的实际位置之间的距离。

然后,系统从预测的点位置开始向后逆转,以返回该点的原始位置。此时,它会测量预测位置与实际起点之间的距离,并且所产生的距离会形成第二种误差。

然后,系统将纠正这些错误。

霍尔德说:“事实证明,要消除这两个错误,系统实际上需要学习做正确的事,而从未被告知正确的事是什么。”

听起来可能有些费解,但发现它运作良好。研究人员使用一组综合数据训练得出的场景流精度仅为25%。当使用少量现实世界中标记的数据对合成数据进行微调时,准确性提高到31%。当他们添加大量未标记的数据来使用他们的方法训练系统时,场景流的准确性跃升至46%。

研究团队在6月14日至19日举行的计算机视觉和模式识别(CVPR)会议上介绍了他们的方法。CMU Argo AI自主车辆研究中心为这项研究提供了支持,并获得了NASA太空技术研究奖学金的额外支持。