4月19日,美国科技媒体 The Information 爆料,ChatGPT背后的大股东微软正在研发自己的芯片“雅典娜”(Athena)。

此次微软公司自研芯片主要应用于 ChatGPT 背后的生成式 AI 技术,用途为训练大语言模型(LLM)和 AI 推理(inference)。

微软早在2019年就已开始著手研发这款芯片。芯片已经提供给了小部分微软的员工,以及ChatGPT开发商 OpenAI 的员工,他们正在测试并使用这些芯片。

资本大佬和初创新星的蜜恋

要说AI 圈里的当红炸子鸡,定是拥有 ChatGPT 技术的OpenAI 莫属,微软则是OpenAI背后的资本方。

早在两方展开密切合作之前,双方都在生存困境中挣扎许久——微软虽为资方巨擘,但在科技圈仍然相当隐忍,在云计算和人工智能领域总有亚马逊和谷歌压制一头。而OpenAI 最初是一家50人的非盈利性质的初创小公司,面临着所有的AI创企一样的问题:AI开发成本翻番、“要理想还是面包”、副总裁带队离职团队溃不成军等问题,时任OpenAI首席技术官的布罗克曼担心被谷歌旗下的DeepMind等对手甩在身后......

从当前审视这个长达五年的ChatGPT产品研发落地的故事,双方陷入“蜜恋”情理之中,同一个赛道,相同的目标和突破诉求,适配的合作者相见恨晚,一拍即合。

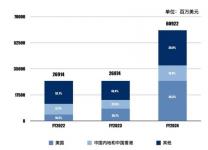

2020年7月,微软向初创公司OpenAI投资10亿美元,自此开始了和OpenAI 的“热恋式合作”。2021年微软再次投资20亿,微软的Azure OpenAI开始集成用户可直接通过相关API进行调用的GPT-3模型,自此GPT技术开始初步商业化。2023年1月24日,微软追加投资100亿,与OpenAI再次扩大合作关系。此轮投资后,微软获得了 OpenAI 75% 的利润分红权直到收回投资,之后微软将拥有 OpenAI 49%分红权。

微软和OpenAI之间的关系逐渐变得更加深入和复杂,他们的财务和技术命运纠缠在一起。他们有共同的目标期许和行业共识,其中一点是明确的:现在还处于早期阶段。

OpenAI持续烧钱,微软探索自研路径

一项新技术航程的初期,借船出海也许能走的更快一些,为了训练ChatGPT,微软下了足够多的血本,但时间一久问题便逐渐暴露。目前,让这对“热恋期情侣”焦灼的是——外购芯片太过烧钱,并非长久之宜。

在用户使用ChatGPT时,这一软件需要识别人类发出的指令,并模仿人类回答相应的问题,这一过程需要处理大量的数据,对芯片算力的要求极高。

微软目前使用的 AI 芯片是英伟达芯片,ChatGPT消耗的总算力约为3640PF-days,假如每秒计算一千万亿次,需要计算3640天。微软将3万多个英伟达A100芯片连起来为OpenAI打造超级算力。这项贴心的举动已耗费微软数亿美元,按照趋势,日后花费只会更甚,还经常会被芯片供应商掣肘。

此举不仅为了减少自身对英伟达 GPU 的依赖,还是应对同行压力的必由之举,随着生成式AI大爆发,包括亚马逊和谷歌等科技巨头都已推出自研AI芯片。

只不过,微软早在5年前就秘密行动了。自研芯片内部代号「雅典娜」(Athena),300人共同研发,并已由微软内部机器学习相关员工和 OpenAI 开发者组成的小团队进行测试。

微软希望 AI 芯片 Athena 的性能优于从其他供应商处购买的芯片,从而节省其在昂贵的AI业务上的时间和成本。

微软的 AI 芯片将用于训练大语言模型并支持推理,这些都是生成式 AI 需要的。我们以 ChatGPT 为例,它需要利用 AI 处理大量数据、识别模式并创建模仿人类对话的全新输出。预计微软将在明年之前将「雅典娜」提供给内部和OpenAI使用。

英伟达,AI芯片的统治者

全球GPU市场中,基本被Nvidia、Intel和AMD三家垄断。目前主导 AI 芯片的是英伟达公司,在机器学习领域,NVIDIA GPU市占率高达95%以上,至今没有对手可以匹敌。

2019 年,前四大云供应商 AWS、谷歌、阿里巴巴和 Azure 中 97.4% 的 AI 加速器实例(用于提高处理速度的硬件)部署了英伟达 GPU。几乎所有 AI 里程碑都发生在英伟达硬件上。

纵观 AI 芯片市场,Nvidia H100 是训练机器学习系统的最流行 GPU 之一,在市场日益短缺的情况下,它在 eBay 等经销商那里的售价高达 40,000 美元。高涨的需求,加上产能的限制,英伟达芯片不仅时常短缺而且价格昂贵,给微软、谷歌这类急于扩充算力的公司形成了较大的压力。越来越多的企业开始使用人工智能来理解他们收集的海量数据,而各国政府则在向深度学习研究领域投入资金以保持领先地位。

显然,整个AI芯片市场都需要更多、更好的人工智能芯片。

挑战者正在试图赶上英伟达在 AI 芯片市场上的统治者地位。2015年,谷歌开始制造自己的芯片;2016年,亚马逊收购 Annapurna Labs 后便将 Alexa 的大脑转移到自己的 Inferentia 芯片上;2019 年,英特尔为其 Xeon 数据中心 CPU 添加了 AI 加速模块。百度拥有昆仑;高通拥有 Cloud AI 100;IBM 正在致力研发一种节能设计;AMD 收购了 Xilinx 用于 AI 数据中心产品等等,越来越多的云服务巨头纷纷自研AI芯片。

有行业分析师评论道,对普通的云计算公司来说,他们的最佳方案是从英伟达那里购买。而对于谷歌、亚马逊这样的巨头来说,自研芯片才是长久之道。