来源 | 产业科技

大洋彼岸的AIGC热浪袭来,国内资本和AI玩家燥热一片。

相比多年以前的Alpha Go大战世界围棋冠军,AI在消费互联网席卷渗透,ChatGPT的出圈更能代表AI迈向纵深发展,标志着人工智能大模型和超级应用起航的新节点。

由于中国在互联网数据上具备优势,AI场景开发及应用并不落后于欧美。与以往的copy模式不同,国内互联网巨头在面临AIGC浪潮时,凭借多年的人才和技术储备,已经从跟随的角色变为主动创新,甚至在中文语境中超越国际选手。

因此,一幅围绕AIGC和AI大模型的内卷镜像也在国内呈现。各家互联网公司掌门人亲自挂帅,你方唱罢我登场,都不愿舍弃在OpenAI掀起的大模型风口中分一杯羹。

云的时代,向来以快制胜,快不仅仅代表对新应用和新功能更加敏捷机动,更彰显企业对市场趋势的前瞻性布局。大模型时代更甚,先知先觉者更快一步,后来者便是跟随。

一如百度和阿里。

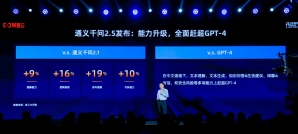

3月16日,百度发布文心一言,打响中文大模型第一枪;二十余天后,阿里董事局主席张勇才在阿里云峰会上正式发布通义千问。百度文心大模型早在2019年就已推出,而阿里通义大模型是阿里达摩院于2022年9月发布。

不只是产品层面的落后,在AI战略层面,阿里同样学步百度。通义千问发布后,阿里首提“云智一体”理念,并将其作为阿里云集团下一个战略方向。其实,“云智一体”并非新概念。

三年前,百度智能云在战略发布中提出了“云智一体”理念,通过云计算和人工智能融合创新,把算力、框架、模型,场景应用打造成标准化产品,进而降低企业获取和使用人工智能的门槛。

阿里乃至更多云计算企业,此时将目光投向“云智一体”,做百度的追随者,恰恰证明AI应用能力是云计算产业基础设施成熟后的核心能力。这种能力更在于“智”的水平,即在智能基础设施之上的通用型AI产品能力。

AIGC开局即卷,抄作业的依然会有。但AI赛道和云智一体本是一场科技马拉松,比拼的是投入和耐力,只有软硬底子皆强,才能真正成为产业所需的AI内核。

从大厂卷起

若将AIGC的主体分类,可大致分为ChatGPT和其他,其中ChatGPT背后站着芯片巨头英伟达和国际大厂微软,与其他AIGC玩家没有可比性。但以大厂视角来看,确有先后优劣之分。

国内,百度在ChatGPT之后,率先推出了自己的AIGC产品文心一言。在市场看来,文心一言问世的意义要比和ChatGPT作比较大得多,虽然尚存差距和不足,但它打开了与百度智能云联动的想象空间,并向外界展示中国科技和世界同步的能力。

一个细节是,李彦宏在文心一言发布会上至少说了三遍“文心一言还不完美”。在他看来,创业公司完全不用担心市场是不是足够大,只有出来之后才有机会更快地去迭代,去提升。

对于如何定位文心一言,李彦宏称文心一言是全世界唯一一个由大厂推出的生成式AI应用。的确,彼时微软只是调用ChatGPT接口,国际大厂谷歌、Facebook也没推出成型的类ChatGPT产品,而亚马逊近期才发布自己的大语言模型。

国内的玩家更不用说,自百度之后纷纷学步,先是阿里悄悄启动企业用户定向内测,后是360、商汤科技、腾讯、京东、华为、科大讯飞磨刀霍霍。

既是大厂自己推出的AIGC,与ChatGPT有何不同呢?从基因来看,大厂基于自身对业务的理解和技术模型沉淀,在AIGC价值创新层面,更注重场景穿透和服务能力,也就是各位掌门人口中的“产业能力”。

更细微的视角是,文心一言由中文大模型生成,具备独特的中文语义理解能力。根据使用者反馈,文心一言独特的中文语义理解,相比ChatGPT等国际产品,更适配中国用户。如在语义问题表达,分析和答案归集层面,匹配度更高。

同处中文大模型赛道,阿里的通义千问与百度的文心一言谁更强,也成为市场关注的焦点。首先在功能层面,文心一言有文学创作、商业文案创作、数理推算、中文理解、多模态生成能力等,而通义千问的功能有创作、回答问题、撰写代码、表达观点等。

横向比较,文心一言的功能更加丰富。尽管通义千问还搭配效率类、生活类、娱乐类的定制模块,但相比之下,文心一言的场景扩展能力更突出。

文心一言还与百度智能云联动,所推出的企业服务板块涵盖企业办公场景、金融服务场景、政务服务场景、商旅服务场景及电商直播场景等。场景内测显示,文心一言企业服务功能能有效提升产业端服务效率,强化服务体验。

其次,评判大模型的优劣根本落脚点在于服务匹配的精准度和逻辑分析的严谨性。以此来看,文心一言也强于通义千问。

据媒体公开测评,被问及“小明的父母生了五个孩子,前四个孩子分别叫大牛、二牛、三牛和四牛,第五个孩子叫什么名字?”文心一言回答第五个孩子叫小明,而通义千问则回答第五个孩子叫小牛。

在创作能力上,让文心一言和通义千问为红楼梦前八十回续写结局,文心一言给出了一个想象的可能结局,把贾宝玉和林黛玉爱情故事变成了一个充满希望和勇气的故事。而通义千问直接表示无法续写结局。

更惊讶的是,问及通义千问何时诞生时,通义千问竟然给出了 “2023年9月2日正式诞生”的答案。这些问题并非时事热点,剔除了训练参数滞后的限制,但通义千问的表现让人失望。

差异的根源在模型参数和复杂度上。对于大模型而言,模型参数规模越大,模型结构设计越复杂,所承载的逻辑分析预测能力越强,给出的答案自然更精准。据了解,在GPT-3阶段,OpenAI为了使模型性能更接近人类,就使用了45TB的数据和近1万亿个单词对其进行训练,大约是1351万本牛津词典。

百度文心一言大模型起步较早,2019年已经推出文心大模型ERNIE1.0版本,2021年基于文心大模型发布全球首个百亿参数的对话大模型PLATO-XL。如今,百度推出更新的ERNIE3.0 Zeus,已经拥有千亿级参数。

数据显示,文心一言的训练数据包括万亿级网页数据、数十亿搜索数据和图片数据、百亿级的语音日均调用数据、超5000亿事实的知识图谱。万亿级数据加上海量用户频繁调用使用,文心一言的学习能力进一步强化,模型泛化和迁移能力决定了其在中文语言处理上更具优势。

数据背后,终极考验AI大模型的底层能力是算法和算力。如果说数据和参数是大模型搭建的基础,那么算法和算力决定了大模型性能有多强,能走多远,这也会继续拉大领跑者与学步者的差距,让GPT玩家们卷到天际。

这一切都是被逼的。

大模型的终极角逐

AI大模型需要在海量数据的基础上,通过AI深度学习算法,训练出深度神经网络模型。从模型训练到模型优化再到应用扩展,都需要强大的算法和算力支撑。

ChatGPT触动AIGC产业爆发,是AI领域数据、算法、算力多年沉淀精进的结果。AIGC之所以能够站上潮头,算法的突破是第一步。

历经近十年迭代,AIGC的算法从第一代生成式对抗网络GAN过渡到深度学习模型CLIP、神经网络架构Transforme,打破了传统AI模型在文本图片关联、自然语言语义分析处理上的障碍。而后,Diffusion扩散模型向语音、图画、视频等领域延伸,进一步强化AI的模仿和创造力。ChatGPT当前采用的就是Transformer算法架构。

于国内AI大模型玩家而言,得益于基础数据和训练参数优势,AI应用探索速度更快,场景渗透更深,互联网巨头已经掌握了前沿的算法框架,算法支撑尚可。

如文心大模型在既有的神经网络模型架构之上,还加入了知识图谱,让模型能够通过先验知识和历史经验理解语义,更加精准地预测提问者的期待和目的。这在中文语境中优势更加明显。

算法之外,AI大模型最短缺的是算力。算力是提升模型性能的基本支撑,不只是AIGC领域,对于整个人工智能产业、产业数字化来讲都至关重要,以至于有不少科学家呼吁算力与电气化同等重要。

黄仁勋既然能喊出ChatGPT是AI的iPhone时刻,ChatGPT背后的英伟达高端芯片支撑是关键。即便有芯片巨头撑腰,ChatGPT发布数月版本几经迭代,仍然存在算力缺口,如ChatGPT付费版ChatGPT Plus暂停付费,OpenAI给出的解释是需求量过大。

AIGC的算力缺口到底有多大?当ChatGPT激起分布式大规模训练浪潮后,摩尔定律限制被打破,算力需求被提升至指数级增长。券商报告显示,训练AI大模型对算力成本消耗量巨大。

“GPT-3训练一次成本约140万美元,对于一些更大的LLM(大型语言模型),训练成本介于200万美元至1200万美元之间。以ChatGPT在1月的独立访客平均数1300万计算,其对应芯片需求为3万多片英伟达A100 GPU,初始投入成本约为8亿美元,每日电费在5万美元左右。”

随着ChatGPT的版本迭代,GPT-4及4+以上版本对算力消耗显著增加,输入成本增加了50%以上,输出成本增加200%以上。因此,为了应付成本和算力缺口,ChatGPT不得不降低用户访问次数,乃至暂停测试项目。

ChatGPT带来的算力恐慌也在国内显现。一方面受地缘政治影响,美国禁止高端芯片设备和人工智能芯片对华出口,直接影响英伟达和AMD等芯片厂商对国内高端芯片需求的供应。即使供应不受限,进口芯片的成本、个性化性能需求和信创安全性也是压力。

另一方面,IDC预测,未来三年新生产的数据量将超过过去三十年综合,未来五年国内智算规模的复合增长率超50%。从电商到直播,从金融到政务,从企服到医疗等,数字化转型提速对算力的需求也会呈现爆发式增长,云计算企业军备竞赛空前紧张。

可以说,目前AI算力缺口根本无法统计,从二级市场中芯片算力概念领涨,也能看出国内算力的紧缺。随着AIGC市场需求上升,比拼算力是大模型企业突围的立足之本,而算力主要技术载体芯片又是关键中的关键。

芯片的制造过程非常复杂,核心分为设计、制造过程,其中设计包含EDA、芯片IP授权、FPGA(万能芯片),制造技术要求高、流程多,往往以全球化、产业链形式呈现。

具体来看,芯片制造包含晶圆、光刻、离子注入、刻蚀、切割封装、量测等环节,每个环节涉及到不同设备,而且不仅技术要求高,投入成本也非常高。以光刻为例,目前国内直接做光刻机的公司几乎没有,一台光刻机需要10万个以上的零部件,价格在10亿元以上。

市场认为,一万枚英伟达A100高端芯片是做好AI大模型的算力门槛,但缺芯恰是中国大模型企业普遍面临的难题。

先发者觉醒

AIGC产品能力的优劣,源于大模型企业在核心技术储备上的强弱。从大厂的AI技术基座来看,领跑者的飞轮效应和非线性增长能力凸显,破局之势出现。

以中文大模型百度为例,文心一言背后,可见昆仑芯高端芯片、飞浆深度学习框架、文心预训练大模型技术基座。

终极算力PK层面,百度芯片自研起步于2010年,是国内最早布局AI加速领域的芯片企业。彼时造芯还属于百度的高度保密项目,起初从FPGA架构研发AI芯片,起点较高,虽然没有完全自研,但对芯片的技术探索领先其他大厂。

2018年7月,百度发布自研芯片“昆仑芯”,2020年量产并应用于AIGC、搜索推荐、自动驾驶、智能终端等板块。

2021年,昆仑芯宣布独立运营,百度芯片首席架构师欧阳剑出任CEO。昆仑芯完成独立融资后,首轮估值达130亿元,中国国产芯片超级独角兽自此诞生。

作为大厂造芯项目,百度芯片的算力逻辑始于复杂场景的处理运算需求。上至百度智能云、无人驾驶,下到搜索基本盘和小度智能终端,百度自研芯片都已经开始跑起来。

支撑文心大模型的昆仑芯在综合算力和成本方面,甚至优于芯片厂商的高端芯片。尽管文心一言相较ChatGPT发布较晚,训练量和模型优化尚且不足,但自主可控的算力资源为模型迭代打下基础。

公开资料显示,昆仑芯2代AI芯片采取7nm工艺打造,这种技术规格在业界处于较高水平,单位体积所能承载的集体管更多,性能更强。昆仑芯的算力可以达到128 TFLOPS@FP16。

为了适应云智一体的算力需求,百度近年来还加紧布局云计算中心,目前拥有阳泉、徐水、定兴三个云计算中心,算力规模在国内大厂前列。

2023年3月,百度完成了阳泉智算中心升级,算力规模达4 EFLOPS,是目前亚洲最大单体智算中心。对比国内整体算力规模,2022年国内服务器规模在2000万台左右,算力规模超150 EFLOPS。

充足的算力为AI大模型训练及产业增智开辟空间,对于百度、阿里,乃至AI后发选手腾讯、京东等大厂而言,面向产业的AIGC大模型输出才是最大的蛋糕。正如阿里张勇所言,面向智能化时代,所有行业都值得重新做一遍。

大模型本为产业而生,是云智一体的产物。从产品功能扩展看,大模型采取了更为原始和非标的数据,基于深度学习算法组织自监督学习,在海量数据训练的基础上,实现智能表达和运算推测。

AI大模型技术应用非常广,包括语音技术、图像识别处理、自然语言处理及大数据分析预测等。在通用AI大模型的基础上,产业场景开发者只需要根据场景需求微调模型,再采用少量数据进行二次训练,就能满足垂直场景下的AI能力调用。

现阶段,具备大模型能力的大厂都已经开始借助大模型的易延展能力,把AIGC接入到产业。如微软将GPT-4整合到旗下的Bing搜索、office办公套件和聊天产品中;阿里计划将旗下所有产品都接入通义千问;百度除了布局百度系产品,把文心一言的战略重点落向了企业服务,强化云智一体的智能化水平,面向多场景输出大模型能力。

目前AI大模型更多集中在C端能力上的优化,未来大模型+产业模型的双模型驱动,会加速向产业数字化渗透,企业经营效率和生产力解放也会达到质的飞跃。

这一变化,领跑者最先看到。

原文标题 : ChatGPT之外,中文大模型开局即卷