决策树停止分支方法:

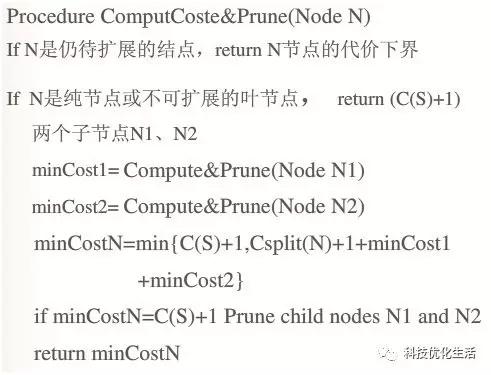

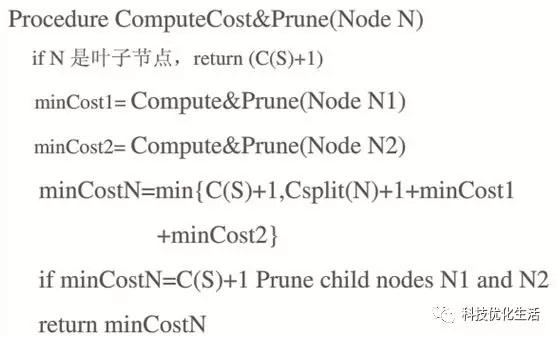

剪枝是决策树停止分支的方法之一,剪枝有分预先剪枝和后剪枝两种。

1)预先剪枝(Public算法)是在树的生长过程中设定一个指标,当达到该指标时就停止生长,容易产生“视界局限”,即一旦停止分支,使得节点N成为叶节点,就断绝了其后继节点进行“好”的分支操作的任何可能性。会误导学习算法,导致产生的树不纯度降差最大的地方过分靠近根节点。

2)后剪枝(Sprint算法)中树首先要充分生长,直到叶节点都有最小的不纯度值为止,因而可以克服“视界局限”。然后对所有相邻的成对叶节点考虑是否消去它们,如果消去能引起令人满意的不纯度增长,那么执行消去,并令它们的公共父节点成为新的叶节点。这种“合并”叶节点的做法和节点分支的过程恰好相反,经过剪枝后叶节点常常会分布在很宽的层次上,树也变得非平衡。后剪枝技术的优点是克服了“视界局限”效应,且无需保留部分样本用于交叉验证,所以可以充分利用全部训练集的信息。但后剪枝的计算量代价比预剪枝方法大得多,特别是在大样本集中,不过对于小样本的情况,后剪枝方法还是优于预剪枝方法的。

决策树与条件概率:

决策树模型呈树形结构,在分类问题中,表示基于特征对实例进行分类的过程。它可以认为是if-then规则的集合,也可以认为是定义在特征空间与类空间上的条件概率分布,即决策树可以依靠计算条件概率来构造。决策树如果依靠数学的计算方法可以取得更加理想的效果。数据库已如下所示:

(x, y) = (x1, x2, x3…, xk, y)

相关的变量 Y 表示尝试去理解,分类或者更一般化的结果。其他的变量x1, x2, x3 等则是帮助达到目的的变量。

决策树常见算法:

决策树的常见的算法包括:1)分类及回归树(Classification And Regression Tree, CART),2)ID3(IterativeDichotomiser 3),3)C4.5,4)Chi-squared Automatic Interaction Detection(CHAID), 5)Decision Stump, 6)随机森林(Random Forest),7)多元自适应回归样条(MARS),8)梯度推进机(Gradient Boosting Machine,GBM)等等。

其中,随机森林(RandomForest)是作为新兴起的、高度灵活的一种决策树算法。它是用训练数据随机的计算出许多决策树,形成了一个森林。然后用这个森林对未知数据进行预测,选取投票最多的分类。此算法的错误率得到了经一步的降低。这种方法背后的原理可以用“三个臭皮匠定一个诸葛亮”这句谚语来概括。一颗树预测正确的概率可能不高,但是集体预测正确的概率却很高。

决策树优点:

1)易于理解和实现:在学习过程中不需要使用者了解很多的背景知识,只要通过解释后都有能力去理解决策树所表达的意义;

2)效率高、效果好:对于决策树,数据的准备往往是简单或者是不必要的,而且能够同时处理数据型和常规型属性,在相对短的时间内能够对大型数据源做出可行且效果良好的结果;

3)易于评测和生成:易于通过静态测试来对模型进行评测,可以测定模型可信度;如果给定一个观察的模型,那么根据所产生的决策树很容易推出相应的逻辑表达式。

决策树缺点:

1)对连续性的字段比较难预测;

2)对有时间顺序的数据,需要很多预处理的工作;

3)当类别太多时,错误可能就会增加的比较快;

4)一般的算法分类的时候,只是根据一个字段来分类。

决策树应用前景:

决策树具有条理清晰,程序严谨,定量、定性分析相结合,方法简单,易于掌握,应用性强,适用范围广等优点。人们逐渐认识到,在投资方案比较选择时考虑时间因素,建立时间可比原则和条件的重要性。当今的社会经济活动中,竞争日趋激烈,现代企业的经营方向面临着许多可供选择的方案,如何用最少的资源,赢得最大的利润以及最大限度地降低企业的经营风险,是企业决策者经常面对的决策问题,决策树法能简单明了地帮助企业决策层分析企业的经营风险和经营方向。必然地,随着经济的不断发展,企业需要做出决策的数量会不断地增加,而决策质量的提高取决于决策方法的科学化。企业的决策水平提高了,企业的管理水平就一定会提高。

结语:

决策树采用的是一种简单且直观的“分而治之”(divide-and-conquer)策略。决策树的核心是通过对数据的学习,选定判断节点,构造一颗合适的决策树。决策树是一个有监督的分类模型,其本质是选择一个能带来最大信息增益的特征值进行树的分割,直到到达结束条件或者叶子结点纯度到达一定阈值。决策树是人工智能之机器学习中比较常见的算法,相比朴素贝叶斯分类,决策树优势在于构造过程不需要任何领域知识或参数设置,因此在实际应用中,对于探测式的知识发现,决策树更加适用,其应用超级广泛。